“お客様が野菜売場で商品を迷い中”スマホでそこまでわかるの?

店長:うーん、どうしたらいいかなぁ

- どうしたんですか?

店長:

今度、スーパーの商品レイアウトを変更したいんだけど、どうすれば本当にお客さんが買い物しやすくなるか、調べる方法はないかなと思ってね。お客さんが目的の商品を探しているときに、どういうところで迷いやすいか傾向がわかれば、それを参考にして、もっとわかりやすいレイアウトにできるんじゃないかと思うんだけど。

- なるほど…。スーパーでお客さんがどんな行動をしているか解析すればいいのか。そうだ、スマホを使ったら調べられるかも。もしかしたらお力になれるかもしれません!

「位置がわかる」から、さらに進化?

原﨑さんをはじめ、西尾研究室のメンバーがやろうとしたのは、スマホのセンサーを使った位置情報の解析。位置情報といえば、GPSを使ったマップやカーナビなどがおなじみですが、今回使われたのは、「PDR」(Pedestrian Dead Reckoning)と呼ばれる技術です。

▲研究の中心となった情報理工学部の原﨑さん

▲研究の中心となった情報理工学部の原﨑さん

- 最近のほとんどのスマホには、加速度や角速度を計測するセンサーが備わっています。PDRとは、そうしたセンサーの情報を解析することで、対象の移動方向と、移動量を推測する手法です。

- 衛星からの電波を受信して測位するGPSとは違い、電波の届かない屋内でも位置情報が計測でき、大掛かりな機器がいらないというメリットがあるんです。

- 実際にスーパーを訪れたお客さんたちに実験の被験者をお願いしました。といっても方法は簡単で、こんな風に用意したスマホをつけて通常通り買い物をしてもらうだけです。

▲このスマホから、お客さんの行動データを集める

▲このスマホから、お客さんの行動データを集める

- まずはPDRによって、お客さんが「店内のどの通路を、どれぐらいの速さで歩いたか」「どこで何秒間立ち止まったか」といった、買い物中の歩行ルートを詳細に計測しました。

- お客さんは、買い物をするとき、目的の商品を探す『検索』、目的の場所に向かう『移動』、そして目的の場所でどの商品を買うか『観察』するという、3つの行動を行います。移動時のスマホのセンサーデータを分析することで、その3つの行動をどのタイミングで行ったかが、分かるのではないかと考えたんです。

被験者はスーパーのお客さん。大規模な実験がスタート!

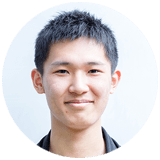

- 実験は夏と冬の2回行いました。夏の実験の目的は、スマホでお客さんの行動を把握するための「AI」を作ること。

▲商品を探しながら移動する『検索』の動き

▲商品を探しながら移動する『検索』の動き

▲立ち止まりどの商品を買おうか考える『観察』の動き

▲立ち止まりどの商品を買おうか考える『観察』の動き

▲目的の場所まで向かう『移動』の動き

▲目的の場所まで向かう『移動』の動き

- 夏の実験ではスマホでお客さんのデータを取りつつ、買い物中の様子をビデオでも撮影しました。実際にどういう行動をしながらルートを辿って買い物を終えたかという『正解データ』を集めるためです。

- その正解データと、スマホから得られた学習用のセンサーデータを照らし合わせることで、PDRの「頭脳」であるAIの精度を高めていきました。

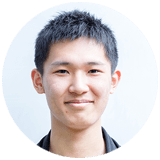

▲実験当日の様子。左から西尾研究室の木下さん、原﨑さん、浅井さん

▲実験当日の様子。左から西尾研究室の木下さん、原﨑さん、浅井さん

- 慣れないことも多くて、結構大変でした(笑)。でもたくさんのお客さんが心よく協力してくださって、本当にありがたかったですね。

ついにできた!お客さんの行動がひと目でわかる「カラフルMAP」

- 夏の実験でスマホのセンサーから歩行ルートを正確に計測できるAIを構築することができたので、冬実験では、実際に520人のお客さんが、どこでどういう行動をしながらルートを辿って買い物をしているか、解析を行いました。買い物をどういうルートで、どれぐらい時間をかけて、どの場所で迷って立ち止まったかを、『検索』、『移動』、『観察』に色分けしてスーパーの地図上にカラー化したのです。

その地図では、『移動』の特徴であるまっすぐに歩いているときには赤色の線、『検索』の特徴であるゆっくりと棚を眺めながら歩いているときは黄色の線、『観察』の特徴である立ち止まっているときには青色というように、買い物客の行動がカラフルに可視化されました。ひと目でお客さんの行動がわかる「カラフルMAP」の完成です。

- カラフルMAPを作る上でルートの推測には、『マップマッチング』という手法を取り入れました。PDRではスマホのデータだけだと、スマホのセンサーはあまり精度が高くないので、小さな誤差を累積して実際には歩けない棚を通り抜けてお客さんが歩いたり、建物の壁を突き破って歩いているような結果が得られることがよくあります。それを、実際のスーパーの地図のデータと統合することで、補正したんです。

- カラフルMAPで可視化された現実のお客さんの行動データは、スーパーに提供する予定です。少しでも改善の役に立てば嬉しいですね。

AIが未来の行動を予測する!?

▲情報理工学部の西尾教授

▲情報理工学部の西尾教授

- これまでスマホでは、『位置がわかる』ということを利用して、さまざまなアプリが開発されてきました。しかし私たちは、『Yahoo! JAPAN研究所』さんとの共同研究を行う中でさらにその先となる、『その場所で何をしているのか』という、その場にいる目的や理由にまで踏み込んで解析を行いました。

- この研究は、センサーと機械学習を組み合わせたAIの技術によって可能になった技術です。今回はスーパーを実験対象としましたが、スーパー以外にもさまざまな場所で応用が可能だと考えています。

- これから先、センサーがさらに高機能化し、より正確で詳細な行動データがとれるようになれば、AIと組み合わせることで『ある商品を買った人が、魚の切り身を買う確率は何%』といったように、人々がどんな行動をとるか、未来予測も可能になるはずです。

原崎さんは、今回の研究を通じて、「高校生のときにはわからなかった、数学を学ぶ意義が理解できました」と語ります。

- 高校生のときに、微分積分の授業で極小値や極大値を求めたり、行列計算やベクトル演算を習ったりしましたが、『いったいこれが世の中の何の役に立つんだろう?』と考えていました。

- あー、めっちゃわかります(笑)。

- 今では、そうした数学の道具が、AIの機械学習や、画像解析を行う上で、必須の手法であることがわかりました。数学の応用の先には、スーパーマーケットのお客さんがより効率的に買い物ができたり、お店の人のレイアウトにヒントを与えたりといった、実社会とのつながりがあるんですよね。それを理解できたのが、研究を通じて得たいちばんの学びです。

世界にないものを作る研究

- 今まだこの世にないものを作る、それが私たちの研究でしょう。そのためには、現時点の技術で何ができて、何ができないのかを、正確に理解しておくことが必要ですね。

最近はAIがブームなこともあり、「多くのデータを放り込めば、勝手にAIが計算してくれる」といったイメージを持つ人もいるかもしれません。しかし、それは大きな間違い、と西尾先生。

- 人間の頭脳とAIはまったく違う仕組みで動いており、AIにも得意なことと、まったく人間に敵わないことがあります。いまAIができないことを、将来できるようにするためには、何が必要なのか。それを考えるためには、AIという仕組みそのものを根本から理解する必要があります。知的探究心が旺盛で、まだこの世に無いものを作り出したい、という熱意を持つ学生たちと、一緒に研究に取り組めると嬉しいですね。